大佬教程收集整理的这篇文章主要介绍了【Python爬虫】☀️万物可爬☀️- Scrayp框架,大佬教程大佬觉得挺不错的,现在分享给大家,也给大家做个参考。

目录

Scrapy概述:

安装Scrapy:

创建一个Scrapy爬虫项目:

1.使用scrapy创建一个工程:

2.创建爬虫文件:

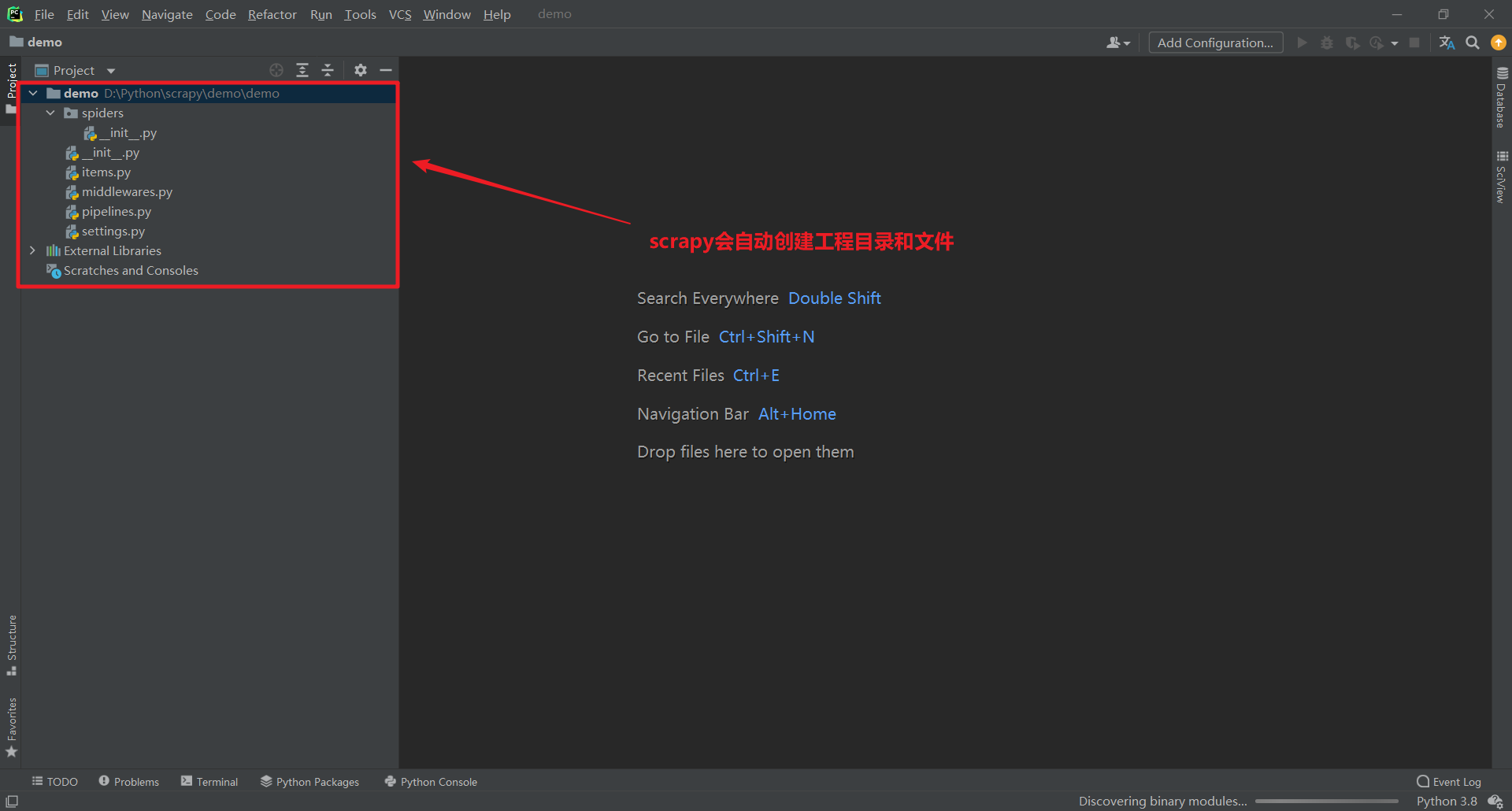

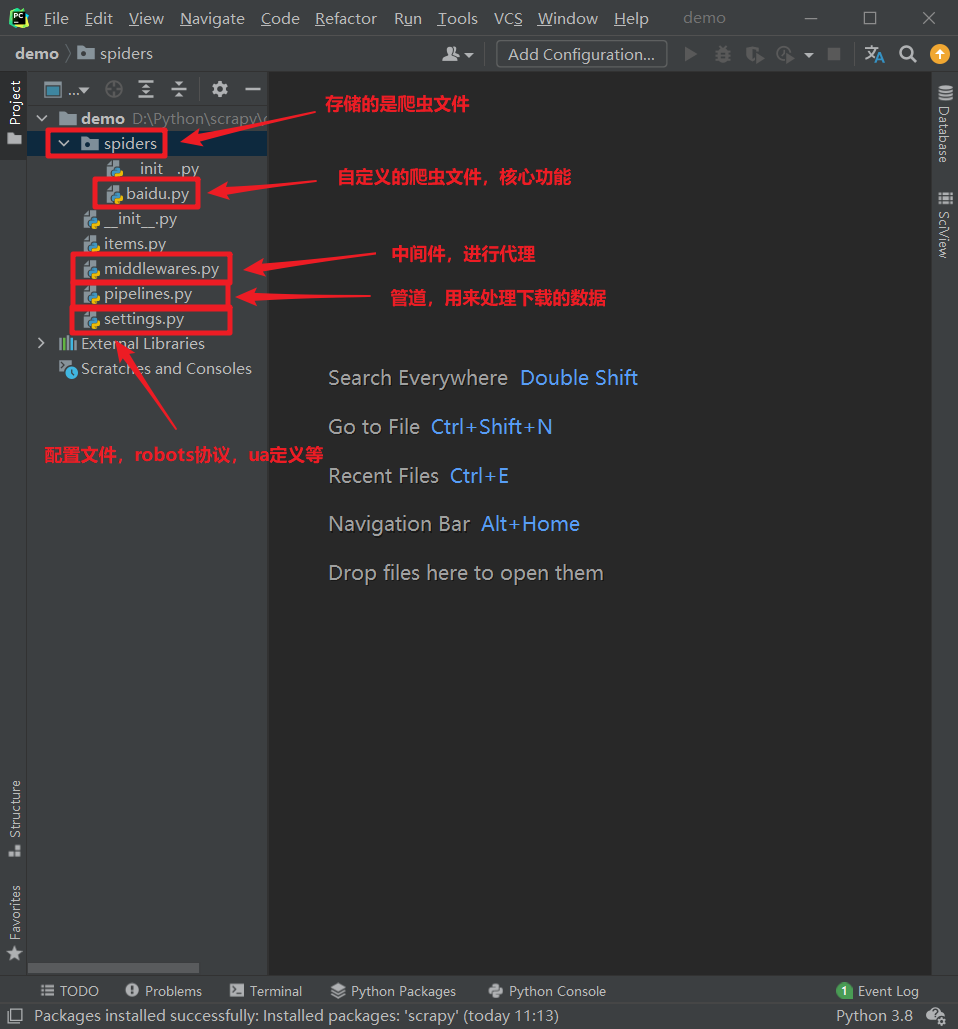

Scrapy项目结构:

response的属性和方法:

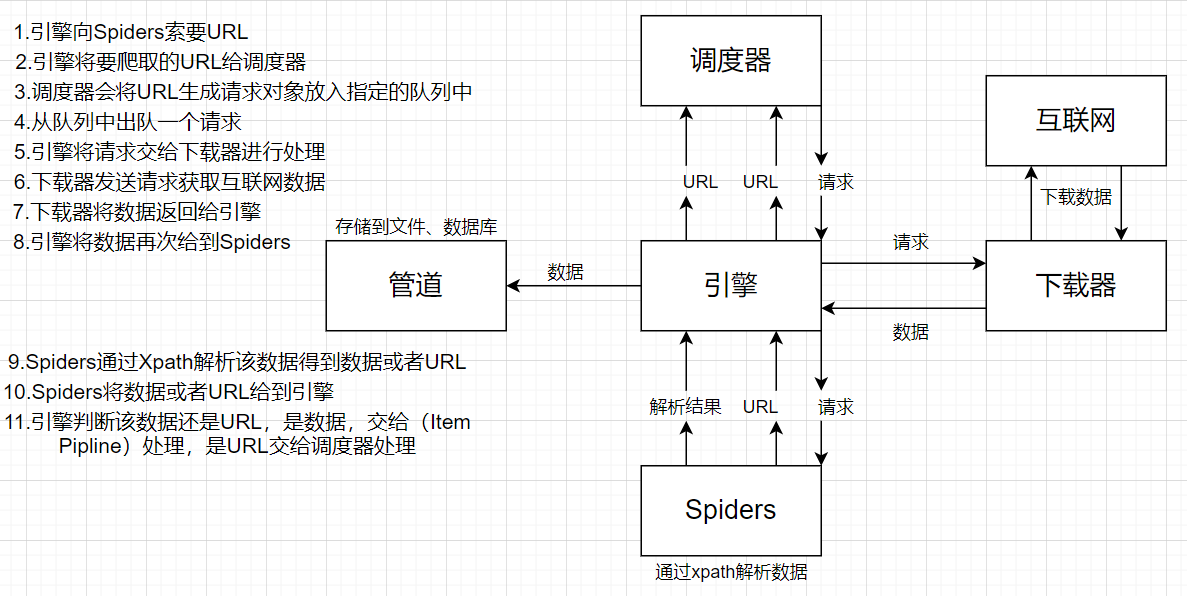

Scrapy架构组成:

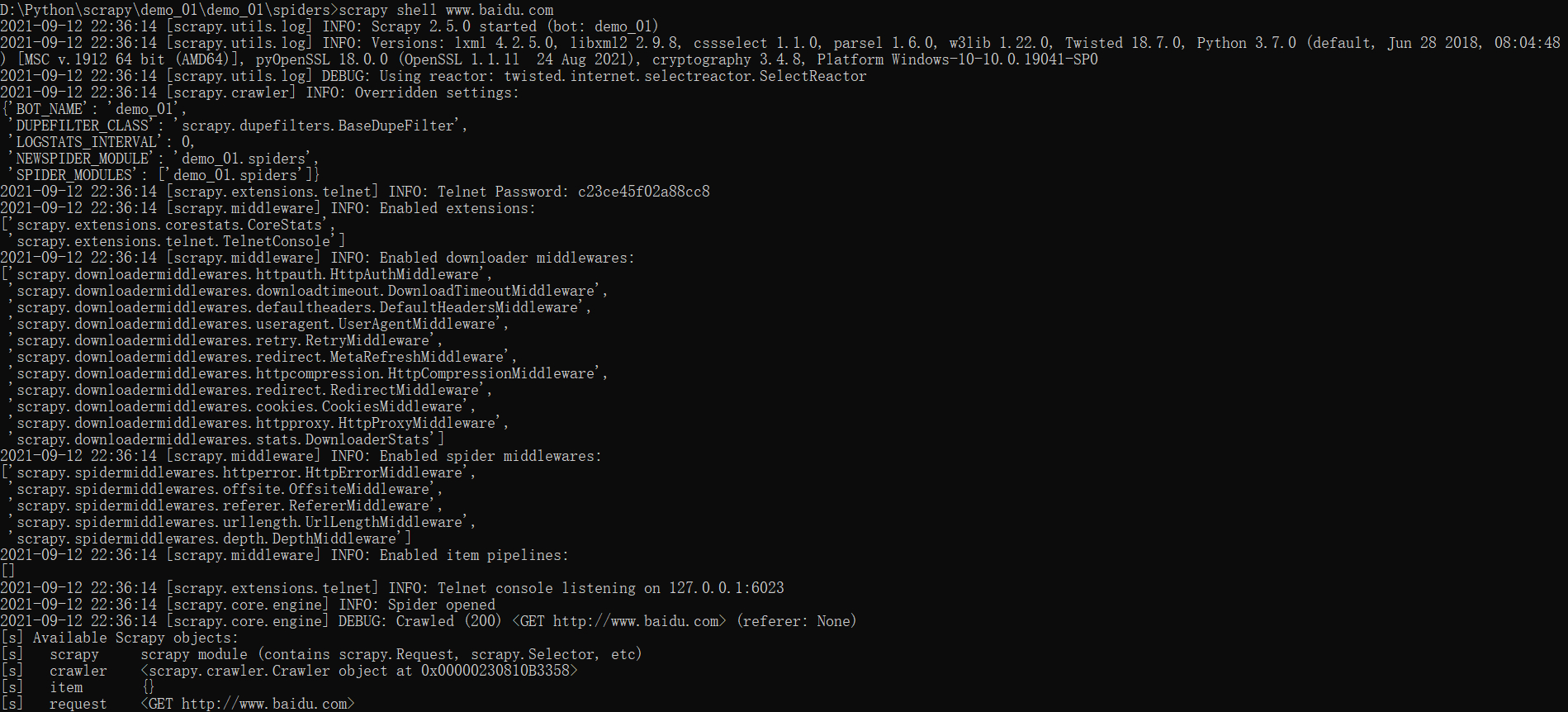

Scrapy SHell:

安装:

应用:

Scrapy是一个为了爬取网站数据c;提取结构性数据而编写的应用框架。可以应用在包括数据挖掘c;信息处理或存储历史数据等一系列的程序中。

pip install scrapy pip install -I cryptographyscrapy startproject scrapy项目名称

注意:项目的名称不允许使用数字开头c;也不能包含中文!

注意:要在spiders文件夹中去创建爬虫文件!

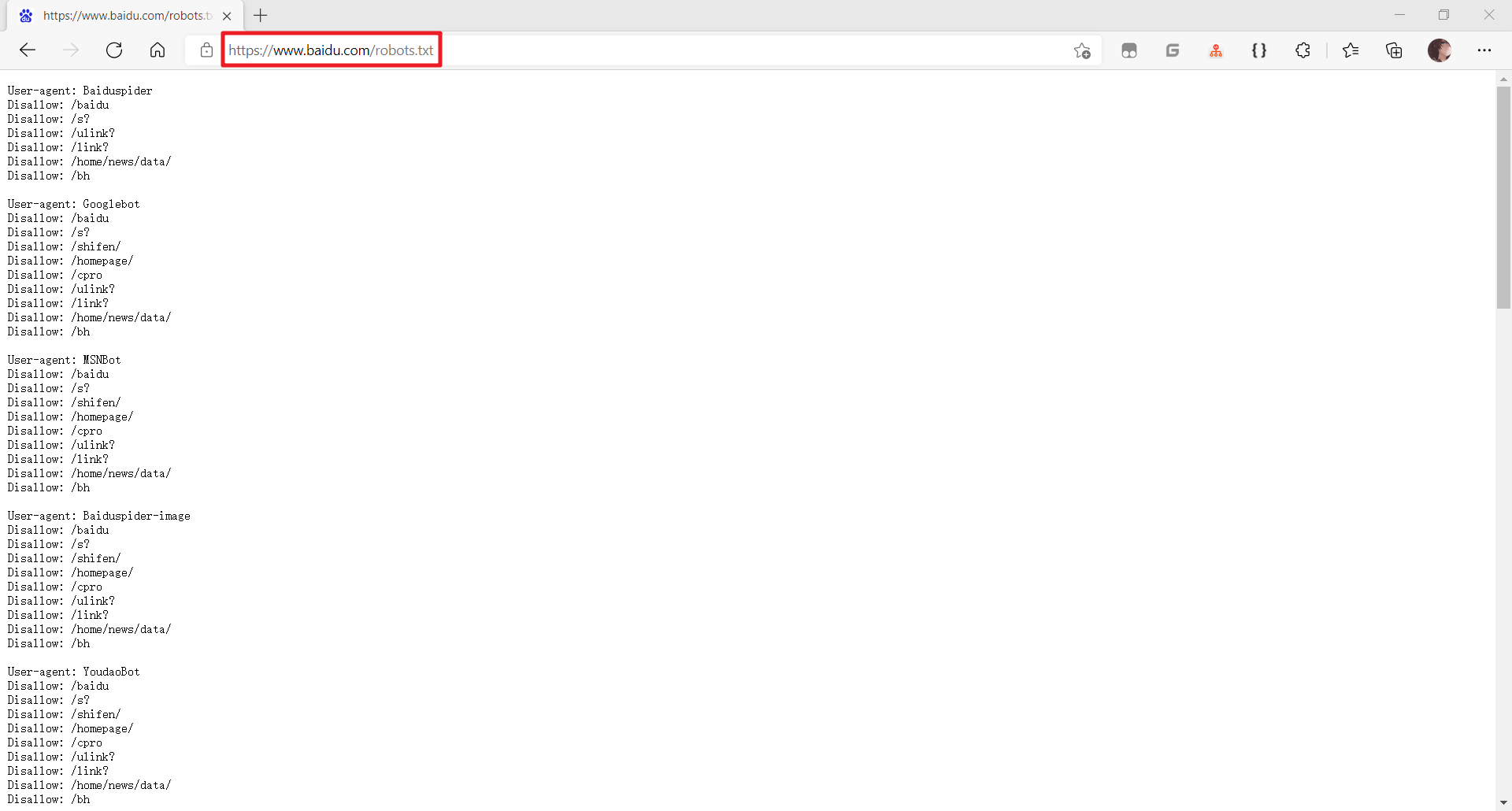

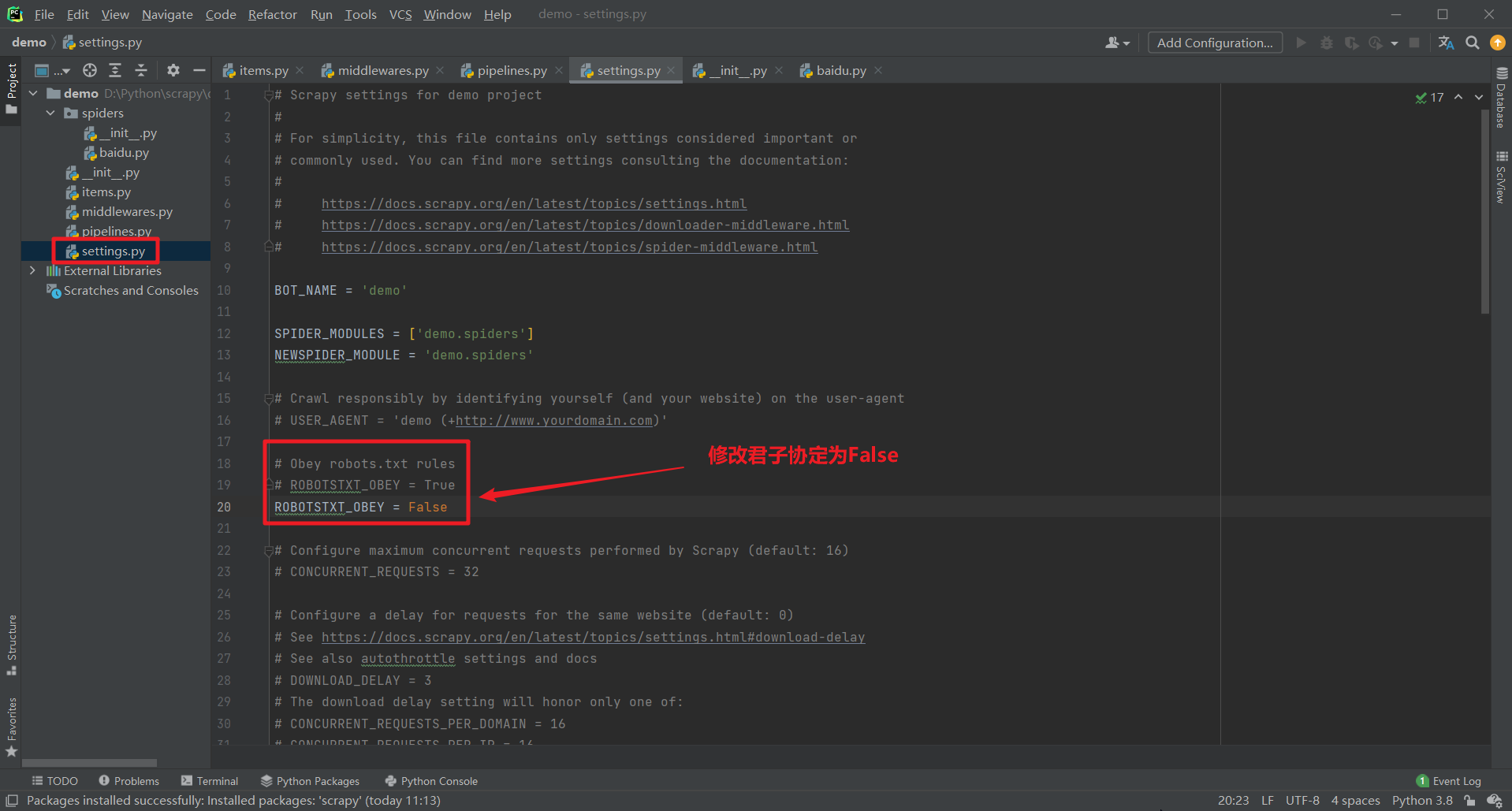

cd 项目名称项目名称spiders修改君子协定:

创建爬虫文件:

scrapy genspider 爬虫文件的名字 要爬取的网页import scrapy

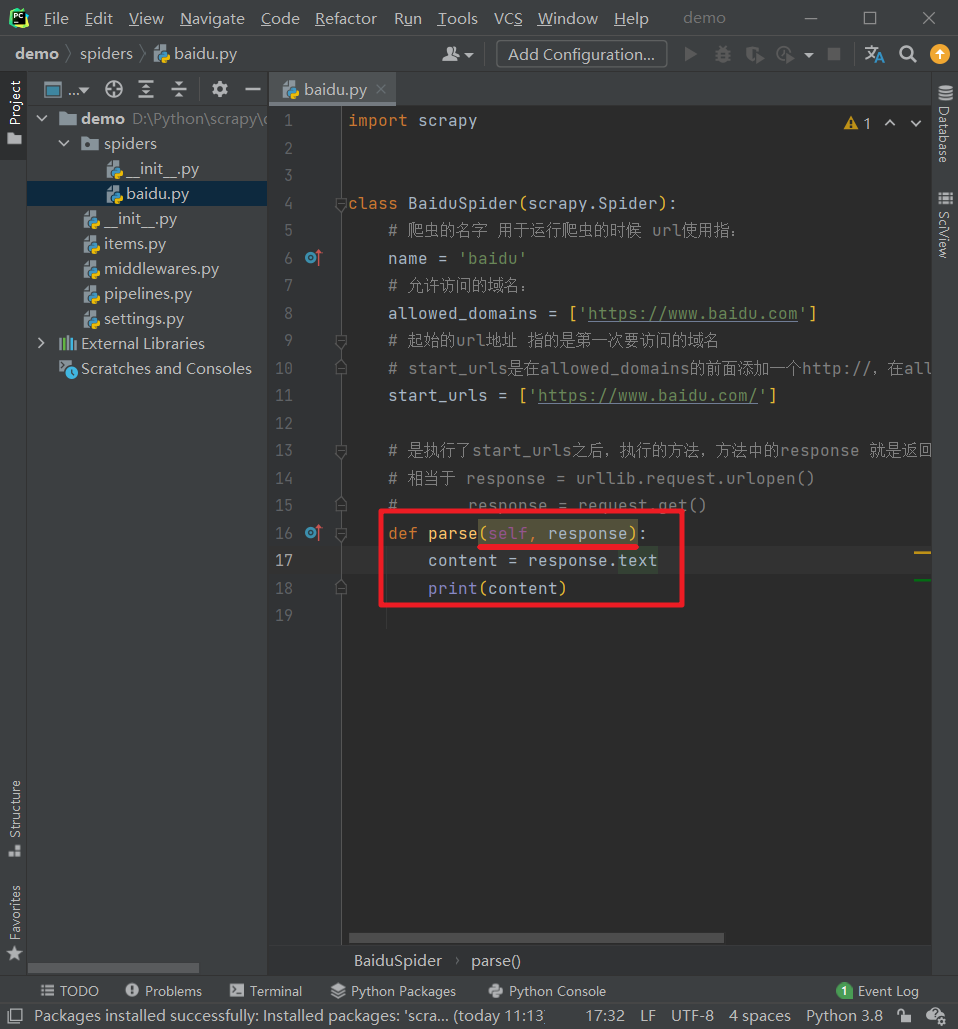

class BaiduSpider(scrapy.Spider):

# 爬虫的名字 用于运行爬虫的时候 url使用指:

name = 'baidu'

# 允许访问的域名:

allowed_domains = ['https://www.baidu.com']

# 起始的url地址 指的是第一次要访问的域名

# start_urls是在allowed_domains的前面添加一个http://c;在allowed_domains后面添加一个/

start_urls = ['https://www.baidu.com/']

# 是执行了start_urls之后c;执行的方法c;方法中的response 就是返回的那个对象

# 相当于 response = urllib.request.urlopen()

# response = request.get()

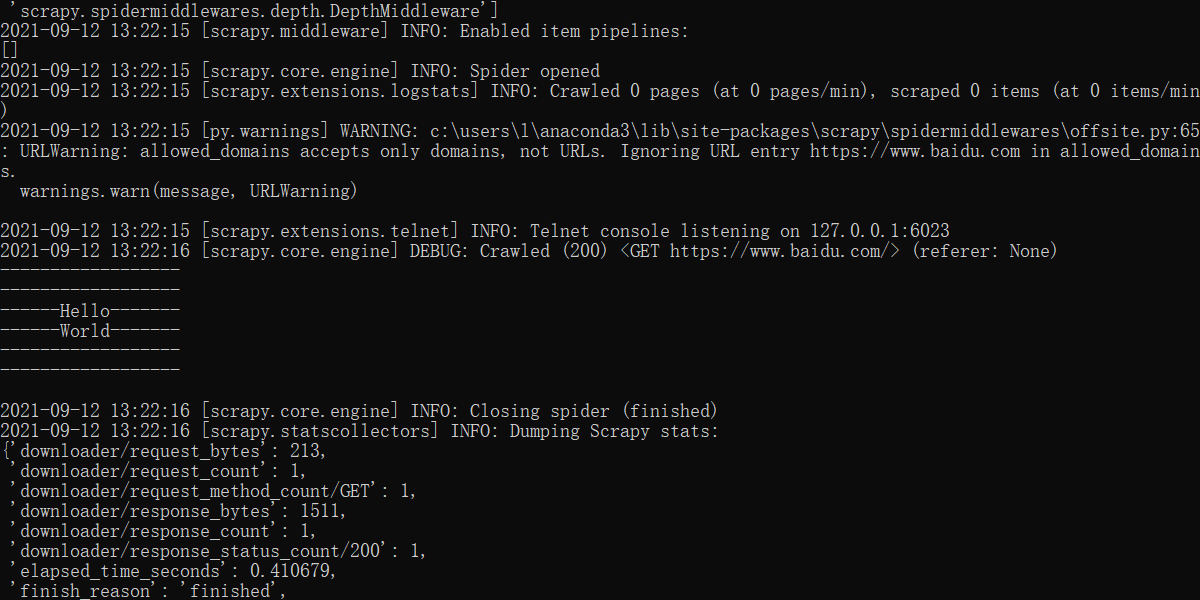

def parse(self, responsE):

print('------------------n'

'------------------n'

'------Hello-------n'

'------World-------n'

'------------------n'

'------------------n')

pass

执行爬虫文件:

scrapy crawl 爬虫文件文件名

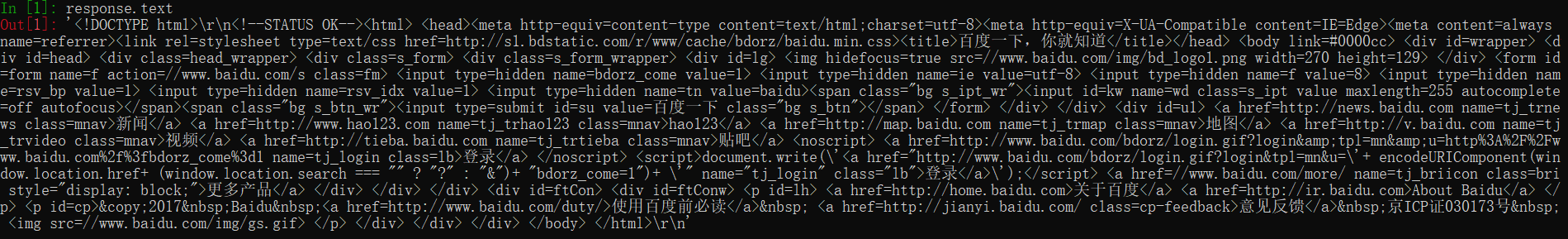

| response.text | 获取的是响应的字符串 |

| response.body | 获取的是二进制数据 |

| response.xpath | 可以直接是xpath方法来解析response中的内容 |

| response.extract() | 提取SELEctor对象的data属性值 |

| response.extract_first() | 提取SELEctor列表的第一个数据 |

以下是item pipline的一些典型应用:

Scrapy终端c;是一个交互终端c;可以在未启动Spider的情况下尝试及调试爬虫代码。其本意是用来测试和提取数据的代码c;不过可以被作为正常的Python终端c;在上面测试任何的Python代码。

该终端用来测试XPath或CSS表达式c;查看他们的工作方式及从网页中提取数据。在编写您的Spider时c;该终端提供了交互性测试您的表达式代码的功能c;免去了每次修改后运行Spider的麻烦。

一旦熟悉Scrapy终端后c;就能发现其在开发和调试Spider时发挥的巨大作用。

pip install ipython

如果安装了IPythonc;Scrapy终端将会使用IPython(代替标准Python终端)c;IPython终端与其他相比较更为强大c;提供智能化的自动补全c;高亮输出c;及其他特性。

scrapy sHell URL地址(爬取指定目标地址)

启动IPthon终端:

| scrapy sHell www.daidu.com |

| scrapy sHell https://www.baidu.com |

| scrapy sHell "https://www.baidu.com" |

| scrapy sHell "www.baidu.com" |

以上是大佬教程为你收集整理的【Python爬虫】☀️万物可爬☀️- Scrayp框架全部内容,希望文章能够帮你解决【Python爬虫】☀️万物可爬☀️- Scrayp框架所遇到的程序开发问题。

如果觉得大佬教程网站内容还不错,欢迎将大佬教程推荐给程序员好友。

本图文内容来源于网友网络收集整理提供,作为学习参考使用,版权属于原作者。

如您有任何意见或建议可联系处理。小编QQ:384754419,请注明来意。